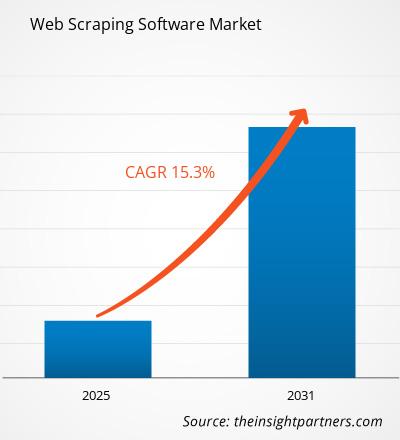

Es wird erwartet, dass der Markt für Web Scraping Software von 2023 bis 2031 eine durchschnittliche jährliche Wachstumsrate (CAGR) von 15,3 % verzeichnet, wobei die Marktgröße von XX Millionen US-Dollar im Jahr 2023 auf XX Millionen US-Dollar im Jahr 2031 wächst.

Der Bericht zum Markt für Web Scraping-Software umfasst Analysen nach Bereitstellungstyp (vor Ort, Cloud), Unternehmensgröße (Großunternehmen, KMU) und Geografie (Nordamerika, Europa, Asien-Pazifik sowie Süd- und Mittelamerika). Die globale Analyse wird weiter auf regionaler Ebene und nach wichtigen Ländern aufgeschlüsselt. Der Bericht bietet den Wert in USD für die oben genannte Analyse und Segmente.

Zweck des Berichts

Der Bericht „Web Scraping Software Market“ von The Insight Partners soll die aktuelle Landschaft und das zukünftige Wachstum sowie die wichtigsten treibenden Faktoren, Herausforderungen und Chancen beschreiben. Dies wird verschiedenen Geschäftspartnern Einblicke geben, wie zum Beispiel:

- Technologieanbieter/-hersteller: Um die sich entwickelnde Marktdynamik zu verstehen und die potenziellen Wachstumschancen zu kennen, damit sie fundierte strategische Entscheidungen treffen können.

- Investoren: Durchführung einer umfassenden Trendanalyse hinsichtlich der Marktwachstumsrate, der finanziellen Marktprognosen und der Chancen entlang der Wertschöpfungskette.

- Regulierungsbehörden: Zur Regulierung von Richtlinien und Überwachungsaktivitäten auf dem Markt mit dem Ziel, Missbrauch zu minimieren, das Vertrauen der Anleger zu bewahren und die Integrität und Stabilität des Marktes aufrechtzuerhalten.

Marktsegmentierung für Web Scraping Software

Bereitstellungstyp

- Vor Ort

- Wolke

Größe der Organisation

- Große Unternehmen

- KMU

Passen Sie diesen Bericht Ihren Anforderungen an

Sie erhalten kostenlos individuelle Anpassungen an jedem Bericht, einschließlich Teilen dieses Berichts oder einer Analyse auf Länderebene, eines Excel-Datenpakets sowie tolle Angebote und Rabatte für Start-ups und Universitäten.

- Holen Sie sich die wichtigsten Markttrends aus diesem Bericht.Dieses KOSTENLOSE Beispiel umfasst eine Datenanalyse von Markttrends bis hin zu Schätzungen und Prognosen.

Wachstumstreiber auf dem Markt für Web Scraping-Software

- Steigende Nachfrage nach datengesteuerter Entscheidungsfindung:

Unternehmen treffen zunehmend datengesteuerte Entscheidungen, und Web Scraping spielt eine entscheidende Rolle beim Sammeln großer Mengen relevanter Daten von Websites, die dann analysiert werden können, um umsetzbare Erkenntnisse abzuleiten. Mit der zunehmenden Verfügbarkeit von Daten im Web nutzen Unternehmen Web Scraping, um ihre Marktintelligenz zu verbessern, die Entscheidungsfindung zu optimieren und wettbewerbsfähig zu bleiben. - Wachstum von E-Commerce und Preisüberwachung:

Der wachsende E-Commerce-Sektor hat die Nachfrage nach Web Scraping-Tools angeheizt. Einzelhändler und E-Commerce-Plattformen nutzen Web Scraping, um die Preise der Konkurrenz zu überwachen, Produktlisten zu verfolgen und Markttrends zu analysieren. Preisinformationen und Wettbewerbsbenchmarking sind für Unternehmen unverzichtbar geworden, um wettbewerbsfähig zu bleiben, was die Nachfrage nach Web Scraping-Software antreibt.benchmarking have become essential for businesses to remain competitive, which drives the demand for web scraping software. - Automatisierung sich wiederholender Datenerfassungsaufgaben:

Web Scraping Tools automatisieren den Prozess der Datenerfassung aus mehreren Quellen, sparen Zeit und reduzieren den manuellen Aufwand. Diese Automatisierung ist besonders für Unternehmen von Vorteil, die regelmäßig umfangreiche Daten erfassen müssen, beispielsweise um Börsentrends zu überwachen, Newsfeeds zu verfolgen oder Produktdetails von verschiedenen Websites zu extrahieren.

Zukünftige Trends auf dem Markt für Web Scraping-Software

- Cloudbasierte Web Scraping-Lösungen:

Cloudbasierte Web Scraping-Lösungen erfreuen sich aufgrund ihrer Skalierbarkeit, Flexibilität und geringeren Anfangsinvestitionen zunehmender Beliebtheit. Unternehmen können auf Cloud-Plattformen für Web Scraping zugreifen, ohne eine eigene Infrastruktur pflegen zu müssen, sodass sie sich auf die Datenerfassung und -analyse konzentrieren können. Diese Lösungen ermöglichen auch eine einfachere Integration mit anderen Cloud-basierten Tools für Analysen und Berichte. - Scraping unstrukturierter Daten:

Es gibt einen wachsenden Trend zum Scraping unstrukturierter Daten wie Bildern, Videos und Social-Media-Inhalten. Unternehmen sind zunehmend daran interessiert, nicht nur Textdaten, sondern auch Multimedia-Inhalte für Anwendungen wie Stimmungsanalyse, Bilderkennung und Social Listening zu scrapen. Fortschrittliche Web-Scraping-Tools werden an die Verarbeitung dieser unterschiedlichen Datentypen angepasst und erweitern so ihren Umfang und Nutzen. - Fokus auf ethisches Scraping und Datenschutz:

Angesichts der zunehmenden Bedenken hinsichtlich Datenschutz und Datensicherheit gibt es einen wachsenden Trend zu ethischen Web-Scraping-Praktiken. Unternehmen konzentrieren sich darauf, Daten im Einklang mit Gesetzen und Vorschriften wie der DSGVO und dem CCPA zu scrapen.

Marktchancen für Web Scraping Software

- Anwendungen zur Lead-Generierung und Kundengewinnung:

Web Scraping wird häufig zur Lead-Generierung verwendet, insbesondere von Unternehmen, die Kontaktdaten, Unternehmensprofile und andere relevante Informationen von Websites wie Social-Media-Plattformen und Branchenverzeichnissen sammeln möchten. Es gibt eine wachsende Chance für Web Scraping-Software in Vertriebs- und Marketingteams, die sich auf die Generierung von Leads und die Gewinnung von Kunden konzentrieren. - Scraping für Finanz- und Anlageeinblicke:

Der Finanzdienstleistungssektor verlässt sich zunehmend auf Web Scraping-Tools, um Echtzeitdaten von Finanznachrichten-Websites, Börsenplattformen und sozialen Medien für Marktanalysen, Stimmungsanalysen und Anlageentscheidungen zu sammeln. Diese wachsende Nachfrage bietet Anbietern von Web Scraping-Software die Möglichkeit, den Finanz- und Anlagesektor gezielt anzusprechen. - Social-Media-Monitoring und Stimmungsanalyse:

Social-Media-Plattformen sind eine reichhaltige Datenquelle, die Unternehmen nutzen können, um die Markenstimmung zu überwachen, Kundenfeedback zu verfolgen und das Verbraucherverhalten zu analysieren. Web Scraping Tools, die Social-Media-Inhalte, Bewertungen und Kommentare effizient scrapen können, sind sehr gefragt. Dies eröffnet Anbietern von Web Scraping-Software die Möglichkeit, Lösungen für Social-Media-Monitoring und Stimmungsanalyse zu entwickeln.

Regionale Einblicke in den Markt für Web Scraping-Software

Die regionalen Trends und Faktoren, die den Markt für Web Scraping Software im Prognosezeitraum beeinflussen, wurden von den Analysten von Insight Partners ausführlich erläutert. In diesem Abschnitt werden auch die Marktsegmente und die Geografie von Web Scraping Software in Nordamerika, Europa, im asiatisch-pazifischen Raum, im Nahen Osten und Afrika sowie in Süd- und Mittelamerika erörtert.

- Erhalten Sie regionale Daten zum Markt für Web Scraping-Software

Umfang des Marktberichts zur Web Scraping Software

| Berichtsattribut | Details |

|---|---|

| Marktgröße im Jahr 2023 | XX Millionen US-Dollar |

| Marktgröße bis 2031 | XX Millionen US-Dollar |

| Globale CAGR (2023 - 2031) | 15,3 % |

| Historische Daten | 2021-2022 |

| Prognosezeitraum | 2024–2031 |

| Abgedeckte Segmente | Nach Bereitstellungstyp

|

| Abgedeckte Regionen und Länder | Nordamerika

|

| Marktführer und wichtige Unternehmensprofile |

|

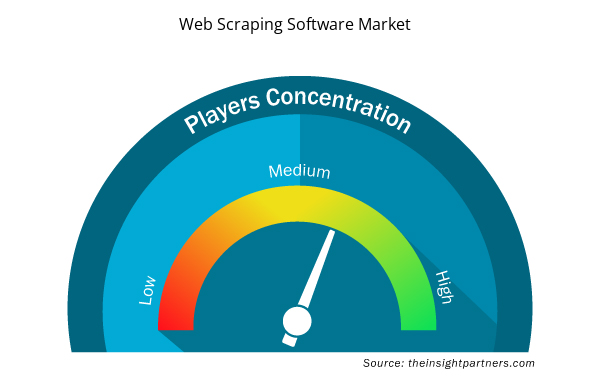

Dichte der Marktteilnehmer für Web Scraping Software: Die Auswirkungen auf die Geschäftsdynamik verstehen

Der Markt für Web Scraping Software wächst rasant, angetrieben durch die steigende Nachfrage der Endnutzer aufgrund von Faktoren wie sich entwickelnden Verbraucherpräferenzen, technologischen Fortschritten und einem größeren Bewusstsein für die Vorteile des Produkts. Mit steigender Nachfrage erweitern Unternehmen ihr Angebot, entwickeln Innovationen, um die Bedürfnisse der Verbraucher zu erfüllen, und nutzen neue Trends, was das Marktwachstum weiter ankurbelt.

Die Marktteilnehmerdichte bezieht sich auf die Verteilung der Firmen oder Unternehmen, die in einem bestimmten Markt oder einer bestimmten Branche tätig sind. Sie gibt an, wie viele Wettbewerber (Marktteilnehmer) in einem bestimmten Marktraum im Verhältnis zu seiner Größe oder seinem gesamten Marktwert präsent sind.

Die wichtigsten auf dem Markt für Web Scraping Software tätigen Unternehmen sind:

- DatenFürSEO

- Diffbot

- Hilfesysteme

- Import.io

- justLikeAPI

Haftungsausschluss : Die oben aufgeführten Unternehmen sind nicht in einer bestimmten Reihenfolge aufgeführt.

- Überblick über die wichtigsten Akteure auf dem Markt für Web Scraping Software

Wichtige Verkaufsargumente

- Umfassende Abdeckung: Der Bericht deckt die Analyse von Produkten, Diensten, Typen und Endbenutzern des Web Scraping Software-Marktes umfassend ab und bietet einen ganzheitlichen Überblick.

- Expertenanalyse: Der Bericht basiert auf dem umfassenden Verständnis von Branchenexperten und Analysten.

- Aktuelle Informationen: Der Bericht stellt durch die Abdeckung aktueller Informationen und Datentrends Geschäftsrelevanz sicher.

- Anpassungsoptionen: Dieser Bericht kann angepasst werden, um spezifische Kundenanforderungen zu erfüllen und die Geschäftsstrategien optimal anzupassen.

Der Forschungsbericht zum Markt für Web Scraping Software kann daher dabei helfen, die Branchensituation und Wachstumsaussichten zu entschlüsseln und zu verstehen. Obwohl es einige berechtigte Bedenken geben kann, überwiegen die allgemeinen Vorteile dieses Berichts tendenziell die Nachteile.

- Historische Analyse (2 Jahre), Basisjahr, Prognose (7 Jahre) mit CAGR

- PEST- und SWOT-Analyse

- Marktgröße Wert/Volumen – Global, Regional, Land

- Branche und Wettbewerbsumfeld

- Excel-Datensatz

Report Coverage

Revenue forecast, Company Analysis, Industry landscape, Growth factors, and Trends

Segment Covered

This text is related

to segments covered.

Regional Scope

North America, Europe, Asia Pacific, Middle East & Africa, South & Central America

Country Scope

This text is related

to country scope.

Häufig gestellte Fragen

Some of the customization options available based on request are additional 3-5 company profiles and country-specific analysis of 3-5 countries of your choice. Customizations are to be requested/discussed before making final order confirmation, as our team would review the same and check the feasibility.

The report can be delivered in PDF/PPT format; we can also share excel dataset based on the request.

Key companies of this market are: DataForSEO, Diffbot, HelpSystems, Import.io, justLikeAPI, Mozenda, Inc., Octopus Data Inc., Scrapinghub, SerpApi, LLC, Webhose.io,

Key future trends in this market are -

The Web Scraping Software Market is estimated to witness a CAGR of 15.3% from 2023 to 2031.

The major factors driving the market are: Demand for data-driven insights, Growth of e-commerce and competitive monitoring, Advancements in automation and AI

Trends and growth analysis reports related to Technology, Media and Telecommunications : READ MORE..

1. DataForSEO

2. Diffbot

3. HelpSystems

4. Import.io

5. justLikeAPI

6. Mozenda, Inc.

7. Octopus Data Inc.

8. Scrapinghub

9. SerpApi, LLC

10. Webhose.io

The Insight Partners performs research in 4 major stages: Data Collection & Secondary Research, Primary Research, Data Analysis and Data Triangulation & Final Review.

- Data Collection and Secondary Research:

As a market research and consulting firm operating from a decade, we have published and advised several client across the globe. First step for any study will start with an assessment of currently available data and insights from existing reports. Further, historical and current market information is collected from Investor Presentations, Annual Reports, SEC Filings, etc., and other information related to company’s performance and market positioning are gathered from Paid Databases (Factiva, Hoovers, and Reuters) and various other publications available in public domain.

Several associations trade associates, technical forums, institutes, societies and organization are accessed to gain technical as well as market related insights through their publications such as research papers, blogs and press releases related to the studies are referred to get cues about the market. Further, white papers, journals, magazines, and other news articles published in last 3 years are scrutinized and analyzed to understand the current market trends.

- Primary Research:

The primarily interview analysis comprise of data obtained from industry participants interview and answers to survey questions gathered by in-house primary team.

For primary research, interviews are conducted with industry experts/CEOs/Marketing Managers/VPs/Subject Matter Experts from both demand and supply side to get a 360-degree view of the market. The primary team conducts several interviews based on the complexity of the markets to understand the various market trends and dynamics which makes research more credible and precise.

A typical research interview fulfils the following functions:

- Provides first-hand information on the market size, market trends, growth trends, competitive landscape, and outlook

- Validates and strengthens in-house secondary research findings

- Develops the analysis team’s expertise and market understanding

Primary research involves email interactions and telephone interviews for each market, category, segment, and sub-segment across geographies. The participants who typically take part in such a process include, but are not limited to:

- Industry participants: VPs, business development managers, market intelligence managers and national sales managers

- Outside experts: Valuation experts, research analysts and key opinion leaders specializing in the electronics and semiconductor industry.

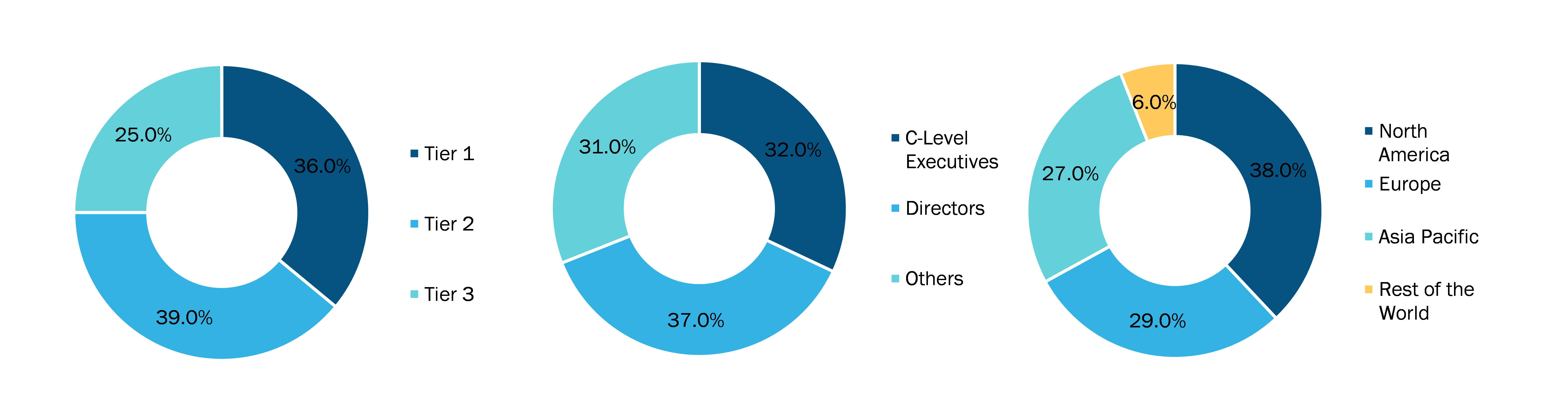

Below is the breakup of our primary respondents by company, designation, and region:

Once we receive the confirmation from primary research sources or primary respondents, we finalize the base year market estimation and forecast the data as per the macroeconomic and microeconomic factors assessed during data collection.

- Data Analysis:

Once data is validated through both secondary as well as primary respondents, we finalize the market estimations by hypothesis formulation and factor analysis at regional and country level.

- Macro-Economic Factor Analysis:

We analyse macroeconomic indicators such the gross domestic product (GDP), increase in the demand for goods and services across industries, technological advancement, regional economic growth, governmental policies, the influence of COVID-19, PEST analysis, and other aspects. This analysis aids in setting benchmarks for various nations/regions and approximating market splits. Additionally, the general trend of the aforementioned components aid in determining the market's development possibilities.

- Country Level Data:

Various factors that are especially aligned to the country are taken into account to determine the market size for a certain area and country, including the presence of vendors, such as headquarters and offices, the country's GDP, demand patterns, and industry growth. To comprehend the market dynamics for the nation, a number of growth variables, inhibitors, application areas, and current market trends are researched. The aforementioned elements aid in determining the country's overall market's growth potential.

- Company Profile:

The “Table of Contents” is formulated by listing and analyzing more than 25 - 30 companies operating in the market ecosystem across geographies. However, we profile only 10 companies as a standard practice in our syndicate reports. These 10 companies comprise leading, emerging, and regional players. Nonetheless, our analysis is not restricted to the 10 listed companies, we also analyze other companies present in the market to develop a holistic view and understand the prevailing trends. The “Company Profiles” section in the report covers key facts, business description, products & services, financial information, SWOT analysis, and key developments. The financial information presented is extracted from the annual reports and official documents of the publicly listed companies. Upon collecting the information for the sections of respective companies, we verify them via various primary sources and then compile the data in respective company profiles. The company level information helps us in deriving the base number as well as in forecasting the market size.

- Developing Base Number:

Aggregation of sales statistics (2020-2022) and macro-economic factor, and other secondary and primary research insights are utilized to arrive at base number and related market shares for 2022. The data gaps are identified in this step and relevant market data is analyzed, collected from paid primary interviews or databases. On finalizing the base year market size, forecasts are developed on the basis of macro-economic, industry and market growth factors and company level analysis.

- Data Triangulation and Final Review:

The market findings and base year market size calculations are validated from supply as well as demand side. Demand side validations are based on macro-economic factor analysis and benchmarks for respective regions and countries. In case of supply side validations, revenues of major companies are estimated (in case not available) based on industry benchmark, approximate number of employees, product portfolio, and primary interviews revenues are gathered. Further revenue from target product/service segment is assessed to avoid overshooting of market statistics. In case of heavy deviations between supply and demand side values, all thes steps are repeated to achieve synchronization.

We follow an iterative model, wherein we share our research findings with Subject Matter Experts (SME’s) and Key Opinion Leaders (KOLs) until consensus view of the market is not formulated – this model negates any drastic deviation in the opinions of experts. Only validated and universally acceptable research findings are quoted in our reports.

We have important check points that we use to validate our research findings – which we call – data triangulation, where we validate the information, we generate from secondary sources with primary interviews and then we re-validate with our internal data bases and Subject matter experts. This comprehensive model enables us to deliver high quality, reliable data in shortest possible time.

Holen Sie sich ein kostenloses Muster für diesen Bericht

Holen Sie sich ein kostenloses Muster für diesen Bericht