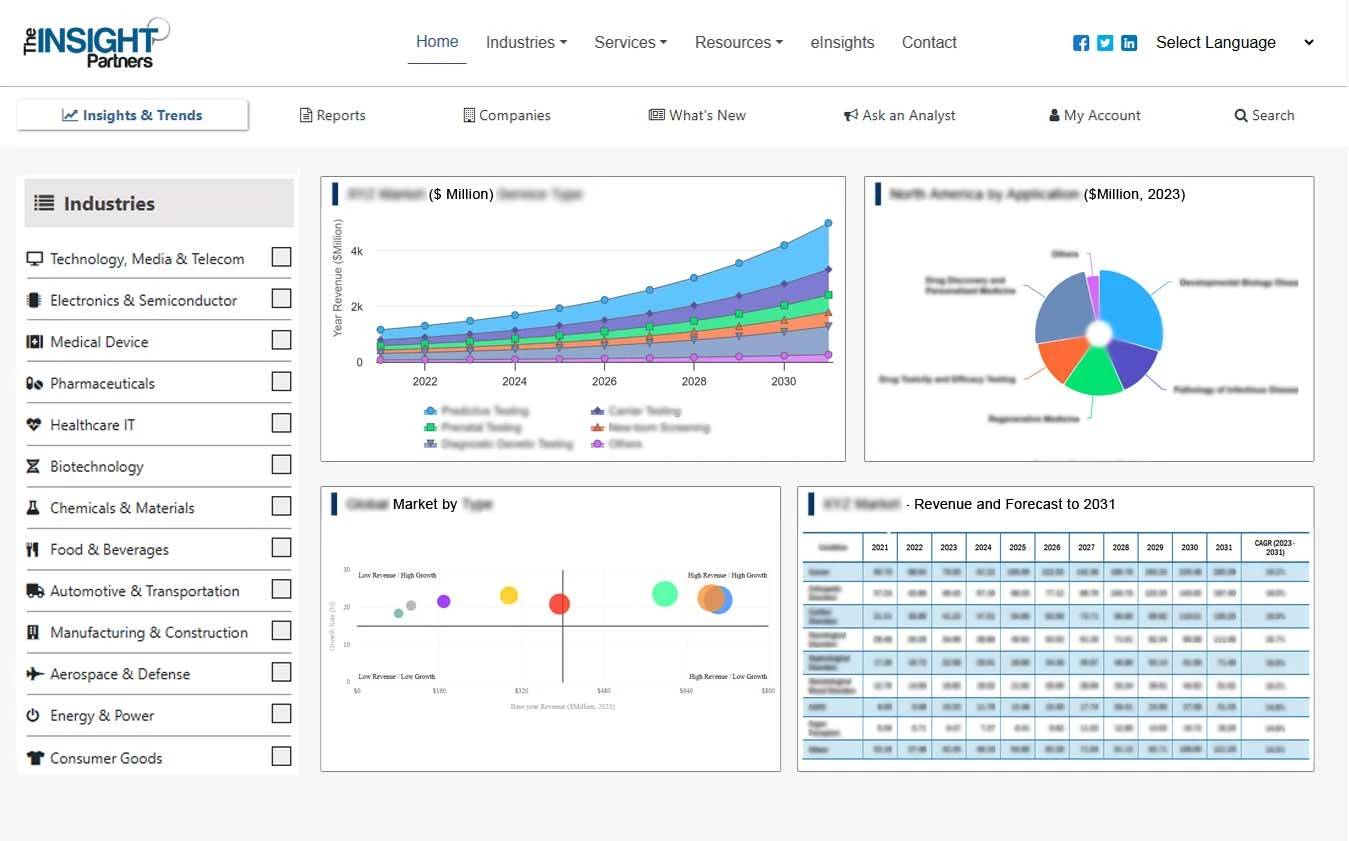

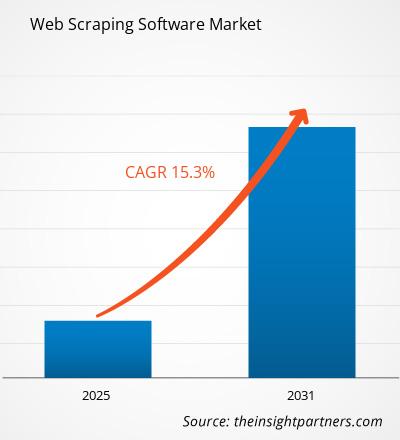

Le marché des logiciels de Web Scraping devrait enregistrer un TCAC de 15,3 % de 2025 à 2031, avec une taille de marché passant de XX millions USD en 2024 à XX millions USD d'ici 2031.

Le rapport sur le marché des logiciels de web scraping analyse les données par type de déploiement (sur site, cloud), taille de l'organisation (grandes entreprises, PME) et zone géographique (Amérique du Nord, Europe, Asie-Pacifique, Amérique du Sud et centrale). L'analyse mondiale est ensuite ventilée par région et par pays. Le rapport présente la valeur en USD des analyses et segments ci-dessus.

Objet du rapport

Le rapport sur le marché des logiciels de web scraping, publié par The Insight Partners, vise à décrire le paysage actuel et la croissance future, les principaux moteurs, les défis et les opportunités. Il fournira des informations aux différents acteurs de l'entreprise, notamment :

- Fournisseurs/fabricants de technologies : pour comprendre l’évolution de la dynamique du marché et connaître les opportunités de croissance potentielles, leur permettant de prendre des décisions stratégiques éclairées.

- Investisseurs : réaliser une analyse complète des tendances concernant le taux de croissance du marché, les projections financières du marché et les opportunités qui existent tout au long de la chaîne de valeur.

- Organismes de réglementation : Réglementer les politiques et les activités de police sur le marché dans le but de minimiser les abus, de préserver la confiance des investisseurs et de maintenir l’intégrité et la stabilité du marché.

Segmentation du marché des logiciels de scraping Web

Type de déploiement

- Sur site

- Nuage

Taille de l'organisation

- Grandes entreprises

- PME

Personnalisez ce rapport en fonction de vos besoins

Vous bénéficierez d'une personnalisation gratuite de n'importe quel rapport, y compris des parties de ce rapport, ou d'une analyse au niveau des pays, d'un pack de données Excel, ainsi que de superbes offres et réductions pour les start-ups et les universités.

Marché des logiciels de web scraping : perspectives stratégiques

- Obtenez les principales tendances clés du marché de ce rapport.Cet échantillon GRATUIT comprendra une analyse de données, allant des tendances du marché aux estimations et prévisions.

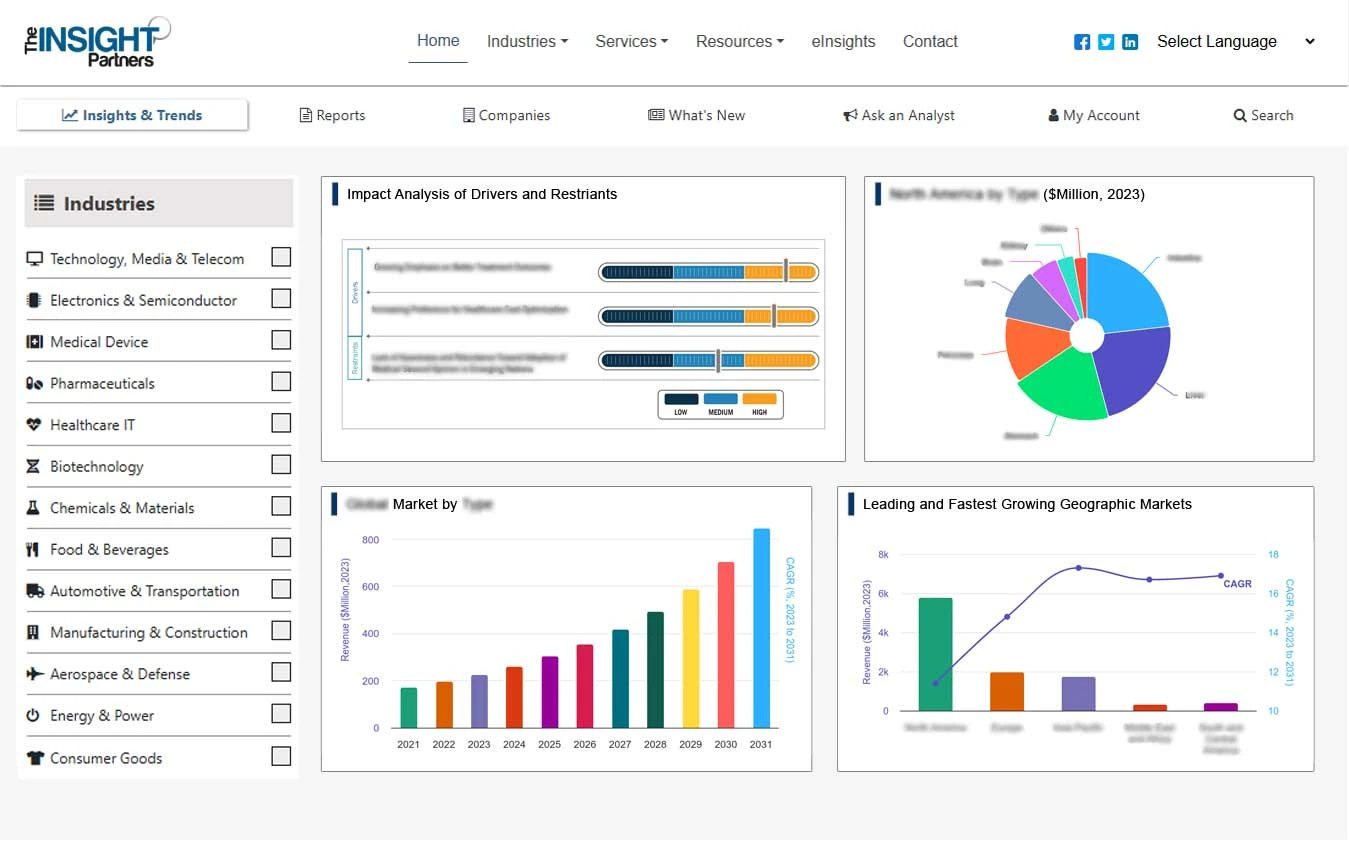

Facteurs de croissance du marché des logiciels de scraping Web

- Demande croissante de prise de décision basée sur les données :

Les entreprises prennent de plus en plus de décisions basées sur les données, et le web scraping joue un rôle crucial dans la collecte de grandes quantités de données pertinentes sur les sites web, qui peuvent ensuite être analysées pour en tirer des informations exploitables. Face à la disponibilité croissante des données sur le web, les entreprises exploitent le web scraping pour améliorer leur connaissance du marché, optimiser leur prise de décision et rester compétitives. - Croissance du e-commerce et surveillance des prix :

La croissance du secteur du e-commerce a stimulé la demande d'outils de web scraping. Les détaillants et les plateformes e-commerce utilisent le web scraping pour surveiller les prix de leurs concurrents, suivre les offres de produits et analyser les tendances du marché. La veille tarifaire et l'analyse comparative de la concurrence sont devenues essentielles pour maintenir la compétitivité des entreprises, ce qui stimule la demande de logiciels de web scraping.benchmarking have become essential for businesses to remain competitive, which drives the demand for web scraping software. - Automatisation des tâches répétitives de collecte de données :

Les outils de web scraping automatisent la collecte de données provenant de sources multiples, ce qui permet de gagner du temps et de réduire les efforts manuels. Cette automatisation est particulièrement avantageuse pour les entreprises qui ont besoin de collecter régulièrement des données à grande échelle, comme le suivi des tendances boursières, le suivi des flux d'actualités ou l'extraction de détails sur les produits à partir de différents sites web.

Tendances futures du marché des logiciels de scraping Web

- Solutions de scraping web dans le cloud :

Les solutions de scraping web dans le cloud gagnent en popularité grâce à leur évolutivité, leur flexibilité et leur faible investissement initial. Les entreprises peuvent accéder à des plateformes cloud pour le scraping web sans avoir à gérer leur propre infrastructure, ce qui leur permet de se concentrer sur la collecte et l'analyse des données. Ces solutions facilitent également l'intégration avec d'autres outils cloud d'analyse et de reporting. - Extraction de données non structurées :

La tendance à extraire des données non structurées, telles que les images, les vidéos et le contenu des réseaux sociaux, est en plein essor. Les entreprises s'intéressent de plus en plus à l'extraction de données non seulement textuelles, mais aussi multimédias pour des applications telles que l'analyse des sentiments, la reconnaissance d'images et l'écoute sociale. Les outils avancés d'extraction de données web s'adaptent pour gérer ces différents types de données, élargissant ainsi leur champ d'application et leur utilité. - Accent sur le scraping éthique et la confidentialité des données :

Face aux préoccupations croissantes en matière de confidentialité et de sécurité des données, on observe une tendance croissante vers des pratiques de scraping éthiques. Les entreprises privilégient un scraping de données conforme aux lois et réglementations telles que le RGPD et le CCPA.

Opportunités du marché des logiciels de Web Scraping

- Applications en génération de leads et acquisition de clients :

Le web scraping est largement utilisé pour la génération de leads, notamment par les entreprises souhaitant collecter des coordonnées, des profils d'entreprise et d'autres informations pertinentes sur des sites web tels que les réseaux sociaux et les annuaires professionnels. Les logiciels de web scraping offrent un potentiel croissant aux équipes commerciales et marketing qui se concentrent sur la génération de leads et l'acquisition de clients. - Scraping pour les informations financières et d'investissement :

Le secteur des services financiers s'appuie de plus en plus sur les outils de scraping web pour collecter des données en temps réel provenant de sites d'actualités financières, de plateformes boursières et de réseaux sociaux, à des fins d'analyse de marché, d'analyse des sentiments et de prise de décisions d'investissement. Cette demande croissante offre aux fournisseurs de logiciels de scraping web une opportunité de cibler les secteurs de la finance et de l'investissement. - Surveillance des médias sociaux et analyse des sentiments :

les plateformes de médias sociaux constituent une source précieuse de données que les entreprises peuvent exploiter pour surveiller l'opinion de leur marque, suivre les retours clients et analyser leur comportement. Les outils de web scraping capables d'extraire efficacement le contenu, les avis et les commentaires des médias sociaux sont très demandés. Cela ouvre des opportunités pour les fournisseurs de logiciels de web scraping afin de créer des solutions de surveillance des médias sociaux et d'analyse des sentiments.

Aperçu régional du marché des logiciels de scraping Web

Les tendances régionales et les facteurs influençant le marché des logiciels de web scraping tout au long de la période de prévision ont été analysés en détail par les analystes d'Insight Partners. Cette section aborde également les segments et la répartition géographique du marché des logiciels de web scraping en Amérique du Nord, en Europe, en Asie-Pacifique, au Moyen-Orient et en Afrique, ainsi qu'en Amérique du Sud et en Amérique centrale.

- Obtenez les données régionales spécifiques au marché des logiciels de scraping Web

Portée du rapport sur le marché des logiciels de scraping Web

| Attribut de rapport | Détails |

|---|---|

| Taille du marché en 2024 | XX millions de dollars américains |

| Taille du marché d'ici 2031 | XX millions de dollars américains |

| TCAC mondial (2025 - 2031) | 15,3% |

| Données historiques | 2021-2023 |

| Période de prévision | 2025-2031 |

| Segments couverts | Par type de déploiement

|

| Régions et pays couverts | Amérique du Nord

|

| Leaders du marché et profils d'entreprises clés |

|

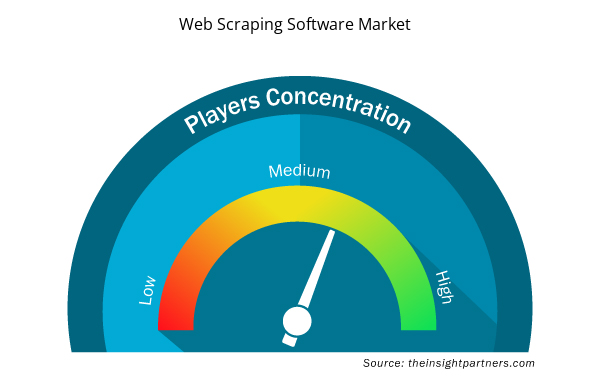

Densité des acteurs du marché des logiciels de scraping Web : comprendre son impact sur la dynamique des entreprises

Le marché des logiciels de web scraping connaît une croissance rapide, portée par une demande croissante des utilisateurs finaux, due à des facteurs tels que l'évolution des préférences des consommateurs, les avancées technologiques et une meilleure connaissance des avantages du produit. Face à cette demande croissante, les entreprises élargissent leur offre, innovent pour répondre aux besoins des consommateurs et capitalisent sur les nouvelles tendances, ce qui alimente la croissance du marché.

La densité des acteurs du marché désigne la répartition des entreprises opérant sur un marché ou un secteur particulier. Elle indique le nombre de concurrents (acteurs) présents sur un marché donné par rapport à sa taille ou à sa valeur marchande totale.

Les principales entreprises opérant sur le marché des logiciels de Web Scraping sont :

- Données pour le référencement

- Diffbot

- Systèmes d'aide

- Import.io

- justeCommeAPI

Avertissement : Les entreprises répertoriées ci-dessus ne sont pas classées dans un ordre particulier.

- Obtenez un aperçu des principaux acteurs du marché des logiciels de scraping Web

Principaux arguments de vente

- Couverture complète : Le rapport couvre de manière exhaustive l'analyse des produits, des services, des types et des utilisateurs finaux du marché des logiciels de Web Scraping, offrant un paysage holistique.

- Analyse d’experts : Le rapport est compilé sur la base d’une compréhension approfondie des experts et analystes du secteur.

- Informations à jour : Le rapport garantit la pertinence commerciale en raison de sa couverture des informations récentes et des tendances des données.

- Options de personnalisation : ce rapport peut être personnalisé pour répondre aux exigences spécifiques des clients et s'adapter de manière appropriée aux stratégies commerciales.

Le rapport de recherche sur le marché des logiciels de web scraping peut donc contribuer à éclairer et à comprendre le contexte et les perspectives de croissance du secteur. Malgré quelques inquiétudes légitimes, les avantages globaux de ce rapport l'emportent généralement sur ses inconvénients.

- Analyse historique (2 ans), année de base, prévision (7 ans) avec TCAC

- Analyse PEST et SWO

- Taille du marché Valeur / Volume - Mondial, Régional, Pays

- Industrie et paysage concurrentiel

- Ensemble de données Excel

Report Coverage

Revenue forecast, Company Analysis, Industry landscape, Growth factors, and Trends

Segment Covered

This text is related

to segments covered.

Regional Scope

North America, Europe, Asia Pacific, Middle East & Africa, South & Central America

Country Scope

This text is related

to country scope.

Questions fréquemment posées

Some of the customization options available based on request are additional 3-5 company profiles and country-specific analysis of 3-5 countries of your choice. Customizations are to be requested/discussed before making final order confirmation, as our team would review the same and check the feasibility.

The report can be delivered in PDF/PPT format; we can also share excel dataset based on the request.

Key companies of this market are: DataForSEO, Diffbot, HelpSystems, Import.io, justLikeAPI, Mozenda, Inc., Octopus Data Inc., Scrapinghub, SerpApi, LLC, Webhose.io,

Key future trends in this market are -

The Web Scraping Software Market is estimated to witness a CAGR of 15.3% from 2023 to 2031.

The major factors driving the market are: Demand for data-driven insights, Growth of e-commerce and competitive monitoring, Advancements in automation and AI

Trends and growth analysis reports related to Technology, Media and Telecommunications : READ MORE..

1. DataForSEO

2. Diffbot

3. HelpSystems

4. Import.io

5. justLikeAPI

6. Mozenda, Inc.

7. Octopus Data Inc.

8. Scrapinghub

9. SerpApi, LLC

10. Webhose.io

The Insight Partners performs research in 4 major stages: Data Collection & Secondary Research, Primary Research, Data Analysis and Data Triangulation & Final Review.

- Data Collection and Secondary Research:

As a market research and consulting firm operating from a decade, we have published and advised several client across the globe. First step for any study will start with an assessment of currently available data and insights from existing reports. Further, historical and current market information is collected from Investor Presentations, Annual Reports, SEC Filings, etc., and other information related to company’s performance and market positioning are gathered from Paid Databases (Factiva, Hoovers, and Reuters) and various other publications available in public domain.

Several associations trade associates, technical forums, institutes, societies and organization are accessed to gain technical as well as market related insights through their publications such as research papers, blogs and press releases related to the studies are referred to get cues about the market. Further, white papers, journals, magazines, and other news articles published in last 3 years are scrutinized and analyzed to understand the current market trends.

- Primary Research:

The primarily interview analysis comprise of data obtained from industry participants interview and answers to survey questions gathered by in-house primary team.

For primary research, interviews are conducted with industry experts/CEOs/Marketing Managers/VPs/Subject Matter Experts from both demand and supply side to get a 360-degree view of the market. The primary team conducts several interviews based on the complexity of the markets to understand the various market trends and dynamics which makes research more credible and precise.

A typical research interview fulfils the following functions:

- Provides first-hand information on the market size, market trends, growth trends, competitive landscape, and outlook

- Validates and strengthens in-house secondary research findings

- Develops the analysis team’s expertise and market understanding

Primary research involves email interactions and telephone interviews for each market, category, segment, and sub-segment across geographies. The participants who typically take part in such a process include, but are not limited to:

- Industry participants: VPs, business development managers, market intelligence managers and national sales managers

- Outside experts: Valuation experts, research analysts and key opinion leaders specializing in the electronics and semiconductor industry.

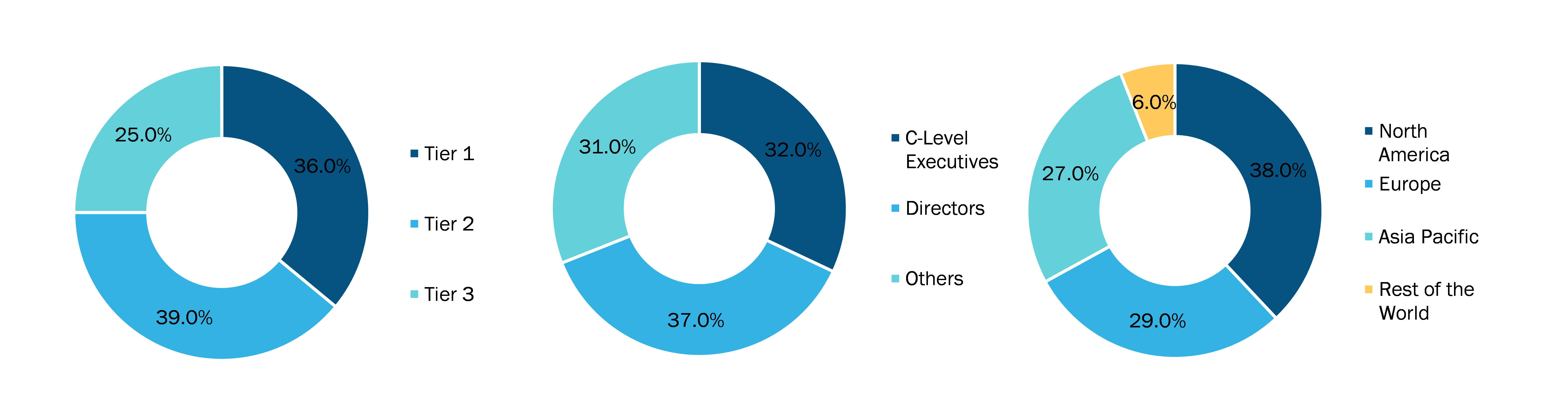

Below is the breakup of our primary respondents by company, designation, and region:

Once we receive the confirmation from primary research sources or primary respondents, we finalize the base year market estimation and forecast the data as per the macroeconomic and microeconomic factors assessed during data collection.

- Data Analysis:

Once data is validated through both secondary as well as primary respondents, we finalize the market estimations by hypothesis formulation and factor analysis at regional and country level.

- Macro-Economic Factor Analysis:

We analyse macroeconomic indicators such the gross domestic product (GDP), increase in the demand for goods and services across industries, technological advancement, regional economic growth, governmental policies, the influence of COVID-19, PEST analysis, and other aspects. This analysis aids in setting benchmarks for various nations/regions and approximating market splits. Additionally, the general trend of the aforementioned components aid in determining the market's development possibilities.

- Country Level Data:

Various factors that are especially aligned to the country are taken into account to determine the market size for a certain area and country, including the presence of vendors, such as headquarters and offices, the country's GDP, demand patterns, and industry growth. To comprehend the market dynamics for the nation, a number of growth variables, inhibitors, application areas, and current market trends are researched. The aforementioned elements aid in determining the country's overall market's growth potential.

- Company Profile:

The “Table of Contents” is formulated by listing and analyzing more than 25 - 30 companies operating in the market ecosystem across geographies. However, we profile only 10 companies as a standard practice in our syndicate reports. These 10 companies comprise leading, emerging, and regional players. Nonetheless, our analysis is not restricted to the 10 listed companies, we also analyze other companies present in the market to develop a holistic view and understand the prevailing trends. The “Company Profiles” section in the report covers key facts, business description, products & services, financial information, SWOT analysis, and key developments. The financial information presented is extracted from the annual reports and official documents of the publicly listed companies. Upon collecting the information for the sections of respective companies, we verify them via various primary sources and then compile the data in respective company profiles. The company level information helps us in deriving the base number as well as in forecasting the market size.

- Developing Base Number:

Aggregation of sales statistics (2020-2022) and macro-economic factor, and other secondary and primary research insights are utilized to arrive at base number and related market shares for 2022. The data gaps are identified in this step and relevant market data is analyzed, collected from paid primary interviews or databases. On finalizing the base year market size, forecasts are developed on the basis of macro-economic, industry and market growth factors and company level analysis.

- Data Triangulation and Final Review:

The market findings and base year market size calculations are validated from supply as well as demand side. Demand side validations are based on macro-economic factor analysis and benchmarks for respective regions and countries. In case of supply side validations, revenues of major companies are estimated (in case not available) based on industry benchmark, approximate number of employees, product portfolio, and primary interviews revenues are gathered. Further revenue from target product/service segment is assessed to avoid overshooting of market statistics. In case of heavy deviations between supply and demand side values, all thes steps are repeated to achieve synchronization.

We follow an iterative model, wherein we share our research findings with Subject Matter Experts (SME’s) and Key Opinion Leaders (KOLs) until consensus view of the market is not formulated – this model negates any drastic deviation in the opinions of experts. Only validated and universally acceptable research findings are quoted in our reports.

We have important check points that we use to validate our research findings – which we call – data triangulation, where we validate the information, we generate from secondary sources with primary interviews and then we re-validate with our internal data bases and Subject matter experts. This comprehensive model enables us to deliver high quality, reliable data in shortest possible time.

Obtenez un échantillon gratuit pour ce rapport

Obtenez un échantillon gratuit pour ce rapport